在金融科技领域,用户画像系统是精准营销、风险控制和产品优化的核心引擎。面对海量、多源、高并发的数据流,如何实现实时、准确、高效的用户画像计算,成为企业技术能力的重要体现。友信金服作为行业领先的金融科技公司,其日处理数据量超过10亿条,通过基于Apache Flink构建的实时用户画像系统,成功解决了这一挑战。本文将深入解析其实践路径与技术架构。

一、 业务挑战与架构选型

友信金服原有的批处理画像系统存在明显的延迟问题,无法满足实时风控、秒级营销推荐等场景的需求。主要挑战包括:

- 数据规模巨大:日处理数据量超过10亿条,涵盖用户行为、交易、设备、外部数据源等。

- 实时性要求高:部分业务场景(如反欺诈、实时授信)需要在毫秒到秒级内完成用户标签的更新与查询。

- 计算逻辑复杂:用户标签涉及多维度统计、模型预测、规则引擎等多种计算模式。

- 系统需要高可用与可扩展:业务快速增长,系统需能弹性伸缩,并保证7x24小时稳定运行。

经过综合评估,Apache Flink因其出色的流处理能力、精确的状态管理和成熟的生态系统被选为核心计算引擎。Flink的“流批一体”理念,特别是其对事件时间、状态管理和Exactly-Once语义的强大支持,非常适合构建低延迟、高一致性的实时用户画像系统。

二、 系统核心架构设计

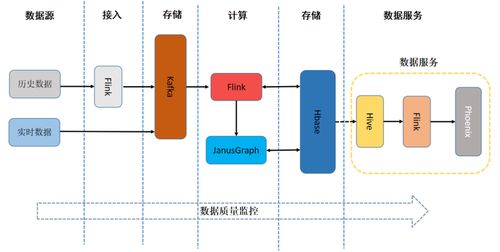

友信金服的实时用户画像系统采用分层架构,确保数据从接入到服务的高效流转:

1. 数据采集与接入层:

- 通过自研的Agent、日志收集系统以及对接Kafka等消息队列,将来自APP、网站、第三方合作方的用户行为、交易流水等数据实时接入。

- 数据经过格式标准化和初步过滤后,统一发送到核心的Kafka集群,作为整个实时数据流的唯一入口。

2. 实时计算层(Flink为核心):

- 流式ETL作业:多个Flink作业并行消费Kafka数据,进行数据清洗、补全、格式转换,并输出到下游。

- 标签计算作业:这是系统的核心。根据标签的计算逻辑(如统计型、规则型、模型预测型),设计不同的Flink作业:

- 统计型标签(如“近1小时点击次数”):利用Flink的滑动/滚动窗口、Keyed State进行聚合计算。

- 规则型标签(如“是否符合某营销活动条件”):集成规则引擎(如Drools),在数据流中动态匹配规则。

- 模型预测型标签(如“信用评分”):将实时特征通过Flink的异步IO或与特征平台对接,调用线上机器学习模型服务获取预测结果。

- 所有计算出的标签更新事件,会实时写入在线存储(如HBase、Redis)和离线数仓(如Hive)做备份与历史分析。

3. 存储与服务层:

- 在线存储:选用HBase作为主存储,以用户ID为RowKey,支持海量标签数据的高并发、低延迟随机读写。热点标签(如实时授信用标签)会缓存在Redis集群中,提供亚毫秒级查询。

- 标签服务:构建统一的标签查询API服务,对内提供毫秒级的标签查询与组合查询能力。服务层集成了缓存、降级、限流等机制保障高可用。

4. 管理与监控层:

- 开发了标签管理平台,用于标签定义、血缘追溯、生命周期管理和数据质量监控。

- 通过Flink Metrics、Prometheus和Grafana对作业延迟、吞吐量、背压、资源使用率进行全方位监控与告警。

三、 关键技术实践与优化

- 状态管理与容错:

- 充分利用Flink的RocksDB状态后端,将用户粒度的中间计算状态(如计数、列表)可靠存储,支持作业失败后快速恢复。

- 精细设置状态TTL,自动清理过期用户数据,控制状态规模。

- 数据倾斜处理:

- 对于“明星用户”等导致的数据倾斜问题,采用“本地聚合+全局聚合”的两阶段聚合方法,或在Key前添加随机前缀进行打散,优化计算资源利用。

- 维表关联优化:

- 频繁变化的维度数据(如产品信息)通过Flink Async I/O进行关联,并利用Guava Cache或Caffeine做本地缓存,减少对外部数据库的查询压力。

- 资源弹性与部署:

- 基于YARN或K8s进行Flink集群部署,根据业务流量峰谷动态调整作业并行度与集群资源,实现成本与效率的平衡。

四、 实践成效与未来展望

通过引入Flink构建实时用户画像系统,友信金服取得了显著成效:

- 实时性飞跃:用户行为触发后,相关标签可在秒级内更新并用于决策,相比T+1的批处理模式有质的提升。

- 支撑核心业务:系统有效支撑了实时反欺诈、精准营销投放、个性化推荐、动态额度管理等关键业务场景,提升了业务转化率和风险控制水平。

- 系统稳定高效:系统日均处理超10亿事件,核心接口P99延迟控制在50毫秒以内,并平稳应对了多次业务高峰挑战。

友信金服计划在以下方向继续深化:

- 向流批一体架构演进:更深入利用Flink SQL和Table API,统一实时与离线标签的开发与管理体验。

- 强化特征工程平台:将实时特征计算能力平台化、标准化,赋能更多AI场景。

- 探索动态更新模型:研究如何在实时数据流中嵌入在线学习,实现用户画像模型的动态实时演进。

###

友信金服的实践表明,基于Apache Flink构建的实时用户画像系统,是处理海量数据、满足金融级实时性要求的有效方案。它不仅解决了传统批处理的延迟瓶颈,更以流式计算的思维方式重塑了数据驱动的业务流程。这一成功实践为金融科技乃至其他数据密集型行业构建实时智能数据系统提供了宝贵参考。技术的价值在于赋能业务,而一个稳定、高效、敏捷的实时数据处理服务,正是金融科技企业实现智能化升级的关键基石。